Table of Contents

Lundi 5 juin, la commissaire européenne en charge des Valeurs et de la Transparence, Věra Jourová, a déploré la décision prise par le réseau social de quitter le code volontaire de bonnes pratiques de l’Union contre la désinformation en ligne.

Les relations entre Twitter et l’Union européenne vont-elles se tendre ? Lundi, la vice-présidente de la Commission européenne Věra Jourová a commenté la décision du géant américain de quitter le code de bonnes pratiques de l’UE contre la désinformation en ligne. “Nous pensons qu’il s’agit d’une erreur de la part de Twitter. Twitter a choisi la manière forte. Il a choisi la confrontation”, a déclaré la commissaire en charge des Valeurs et de la Transparence.

Le 26 mai dernier, le réseau social dirigé par le milliardaire américain Elon Musk annonçait sa décision de se retirer de ce code lancé en 2018 puis renforcé en 2022. Bien qu’il ne soit pas contraignant, ses signataires se sont engagés à prendre des mesures contre la désinformation en ligne. Ils doivent notamment prévenir la rémunération des producteurs de fausses informations à travers la publicité ou encore mieux collaborer avec les fact-checkers. Aujourd’hui, une trentaine d’acteurs du numérique (Google, TikTok, Meta…), mais aussi de la publicité, de la technologie de pointe ou encore de la société civile sont actuellement signataires.

L’action de l’Union européenne contre la désinformation en 3 minutes

Le DSA pour prendre le relai ?

Un autre texte européen devrait prochainement changer la donne : le règlement sur les services numériques ou DSA (pour Digital Services Act). “Au-delà des engagements volontaires, la lutte contre la désinformation sera une obligation légale en vertu du DSA à partir du 25 août”, avait ainsi averti Thierry Breton à l’annonce de Twitter fin mai. Le commissaire en charge du Marché intérieur avait alors signalé que “[ses] équipes [seraient] prêtes à faire appliquer la loi”.

Afin de limiter la diffusion de contenus illicites, le DSA imposera certaines obligations aux fournisseurs de services et notamment aux plateformes. Cependant, la désinformation ne sera pas tout à fait concernée au même plan. Le texte a pour but de limiter la propagation des fausses informations, non par leur suppression, qui serait contraire à la liberté d’expression. Il exige toutefois des plateformes qu’elles revoient les mécanismes (algorithmes) permettant leur amplification.

Rappel sur le DSA

Le règlement vient renforcer les obligations de modération des plateformes, services de stockage et fournisseurs d’accès à internet à l’égard des contenus et produits illicites (racisme et haine, pédopornographie, contrefaçon, désinformation…). Ceux-ci devront par exemple les retirer dès qu’ils en auront pris connaissance. En parallèle, le DSA oblige les plateformes à faire preuve de plus de transparence vis-à-vis de leurs utilisateurs en matière d’utilisation de leurs données personnelles, que les internautes pourront mieux contrôler.

En cas de non-respect des règles du DSA, les fournisseurs de services en ligne encourront des amendes allant jusqu’à 6 % de leur chiffre d’affaires mondial.

Aujourd’hui, la législation sur les services numériques, un ensemble de règles de l’UE qui fera date en créant un environnement en ligne sûr et responsable, entre en vigueur. La législation sur les services numériques s’applique à tous les services numériques qui relient les consommateurs à des biens, services ou contenus. Elle crée de nouvelles obligations globales pour les plateformes en ligne afin de réduire les dommages et de lutter contre les risques en ligne, instaure de solides protections des droits des utilisateurs en ligne et place les plateformes numériques dans un nouveau cadre unique en matière de transparence et de responsabilité. Conçues comme un ensemble unique et uniforme de règles pour l’UE, ces règles offriront aux utilisateurs de nouvelles protections et une sécurité juridique pour les entreprises dans l’ensemble du marché unique. La législation sur les services numériques est une boîte à outils réglementaire pionnière à l’échelle mondiale et établit une référence internationale pour une approche réglementaire à l’égard des intermédiaires en ligne.

Nouvelles responsabilités en matière de services numériques

La législation sur les services numériques introduit un nouvel ensemble complet de règles pour les services intermédiaires en ligne sur la manière dont ils doivent concevoir leurs services et leurs procédures. Les nouvelles règles prévoient de nouvelles responsabilités visant à limiter la diffusion de contenus illicites et de produits illicites en ligne, à renforcer la protection des mineurs, à offrir aux utilisateurs un plus grand choix et à améliorer l’information. Les obligations des différents acteurs en ligne correspondent à leur rôle, à leur taille et à leur impact dans l’écosystème en ligne: une vue d’ensemble est disponible ici.

Tous les intermédiaires en ligne devront se conformer à de nouvelles obligations étendues de transparence afin d’accroître la responsabilité et le contrôle, par exemple un nouveau mécanisme de signalement des contenus illicites. Un régime spécial est prévu pour les plateformes comptant plus de 45 millions d’utilisateurs: pour ces très grandes plateformes en ligne ou très grands moteurs de recherche, des obligations supplémentaires s’appliquent, notamment des évaluations annuelles approfondies des risques de préjudices en ligne sur leurs services, par exemple en lien avec l’exposition à des biens ou contenus illicites ou à la diffusion de la désinformation. Dans le cadre de la législation sur les services numériques, des mesures appropriées d’atténuation des risques devront être mises en place et soumises à un audit indépendant de leurs services et des mesures d’atténuation.

Les petites plateformes et les jeunes pousses bénéficieront d’un ensemble réduit d’obligations, de dérogations spéciales à certaines règles et d’une plus grande clarté et sécurité juridique essentielles pour l’ensemble du marché unique de l’UE.

Renforcement des garanties en matière de droits fondamentaux en ligne

Les nouvelles règles protègent également les droits fondamentaux des utilisateurs dans l’UE dans l’environnement en ligne. De nouvelles protections de la liberté d’expression limiteront les décisions arbitraires prises par les plateformes en matière de modération des contenus et offriront aux utilisateurs de nouveaux moyens pour agir en connaissance de cause à l’encontre de la plateforme lorsque leur contenu est modéré: par exemple, les utilisateurs des plateformes en ligne disposeront désormais de multiples moyens pour contester les décisions de modération des contenus, y compris lorsque ces décisions sont fondées sur les conditions générales des plateformes. Les utilisateurs peuvent introduire une plainte directement auprès de la plateforme, choisir un organisme de règlement extrajudiciaire des litiges ou demander réparation devant les tribunaux.

Les nouvelles règles exigent également que les conditions générales des plateformes soient présentés de manière claire et concise et respectent les droits fondamentaux des utilisateurs.

Les très grandes plateformes en ligne et les très grands moteurs de recherche devront en outre procéder à une évaluation complète des risques pour les droits fondamentaux, notamment la liberté d’expression, la protection des données à caractère personnel, la liberté et le pluralisme des médias en ligne ainsi que les droits de l’enfant.

Nouveaux pouvoirs de surveillance de la Commission

La législation sur les services numériques crée un niveau sans précédent de contrôle public des plateformes en ligne dans l’ensemble de l’Union, tant au niveau national qu’au niveau de l’UE. La Commission est habilitée à surveiller directement les très grandes plateformes en ligne et les très grands moteurs de recherche, entreprises qui touchent individuellement plus de 10 % de la population de l’UE, soit environ 45 millions de personnes. En outre, chaque État membre devra désigner un coordinateur pour les services numériques, qui supervisera les autres entités relevant du champ d’application de la législation sur les services numériques ainsi que les très grandes plateformes en ligne et les très grands moteurs de recherche pour les questions non systémiques. Les coordinateurs nationaux et la Commission européenne coopéreront par l’intermédiaire d’un comité européen des services numériques. Ce mécanisme de coopération à l’échelle de l’UE sera mis en place entre les régulateurs nationaux et la Commission.

La Commission met actuellement en place un Centre européen pour la transparence des algorithmes (ECAT) afin de soutenir son rôle de surveillance grâce à des connaissances pluridisciplinaires internes et externes. Le Centre apportera son soutien aux évaluations visant à déterminer si le fonctionnement des systèmes algorithmiques est conforme aux obligations en matière de gestion des risques que la législation sur les services numériques établit pour les très grandes plateformes en ligne et les très grands moteurs de recherche afin de garantir un environnement en ligne sûr, prévisible et fiable.

Prochaines étapes

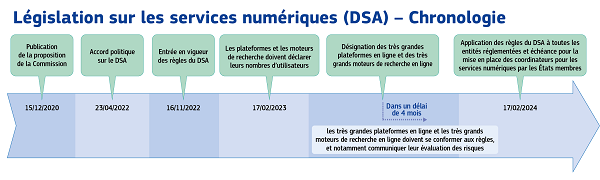

À la suite de l’entrée en vigueur de la législation sur les services numériques aujourd’hui, les plateformes en ligne disposeront de 3 mois pour déclarer le nombre d’utilisateurs finaux actifs (17 février 2023) sur leurs sites web. La Commission invite également toutes les plateformes en ligne à lui notifier les nombres publiés. Sur la base de ces nombres d’utilisateurs, la Commission évaluera si une plateforme devrait être désignée comme très grande plateforme en ligne ou un très grand moteur de recherche. À la suite d’une telle décision de désignation de la Commission, l’entité en question disposera de 4 mois pour se conformer aux obligations découlant de la législation sur les services numériques, y compris la réalisation et la présentation à la Commission du premier exercice annuel d’évaluation des risques. Les États membres de l’UE devront habiliter leurs coordinateurs pour les services numériques au plus tard le 17 février 2024, date générale d’entrée en application de la législation sur les services numériques, qui sera alors pleinement applicable à toutes les entités entrant dans son champ d’application.

Contexte

Contexte

Le 15 décembre 2020, la Commission a présenté la proposition relative à la législation sur les services numériques ainsi que la proposition relative à la législation sur les marchés numériques en tant que cadre global visant à garantir un espace numérique plus sûr et plus équitable pour tous. La législation sur les marchés numériques est entré en vigueur le 1er novembre 2022.

Les services numériques englobent un large éventail de services en ligne, depuis les sites web simples jusqu’aux services d’infrastructure internet et aux plateformes en ligne. Les règles énoncées dans la législation sur les services numériques concernent principalement les intermédiaires et les plateformes en ligne. Par exemple, les places de marché en ligne, les réseaux sociaux, les plateformes de partage de contenus, les boutiques d’applications et les plateformes de voyage et d’hébergement en ligne.

Pour en savoir plus

Texte publié au Journal officiel de l’UE

Législation sur les services numériques

Législation sur les services numériques

Paquet relatif aux services numériques |

Plus de 10 000 plateformes en ligne opèrent aujourd’hui sur le marché européen du numérique, estime la Commission européenne. Pourtant, seule une toute petite partie d’entre elles capterait l’essentiel de la valeur générée par ces activités.

S’ils ne sont pas directement cités, les GAFAM (Google, Apple, Facebook, Amazon et Microsoft) et autres géants du secteur sont les principales cibles des deux textes proposés le 15 décembre 2020 par l’exécutif européen : le règlement sur les marchés numériques (Digital Markets Act, ou DMA) et le règlement sur les services numériques (Digital Services Act, ou DSA).

Le premier vise à mieux encadrer les activités économiques des plus grandes plateformes. Celles-ci sont qualifiées par la Commission de “contrôleurs d’accès” pour indiquer qu’elles sont devenues des passages obligés afin de bénéficier des avantages d’internet. Elles sont accusées de rendre les entreprises et les consommateurs particulièrement dépendants de leurs services et d’empêcher la concurrence des autres sociétés.

Le second, qui modernise une partie de la directive de 2000 sur le commerce électronique jusque-là inchangée, s’attaque quant à lui aux contenus (haineux, pédopornographiques, terroristes…) et aux produits illicites (contrefaits ou dangereux) proposés en ligne. Il cherche notamment à harmoniser les législations nationales déjà en place dans les Etats membres en la matière et a pour mot d’ordre : “ce qui est illégal hors ligne doit également être illégal en ligne”.

Régulation du numérique : “L’Union européenne est une source d’inspiration”

Le 12 octobre 2022, soit près de deux ans après la proposition de la Commission, le DMA a été publié au journal officiel de l’Union européenne. Il entrera en application le 2 mars 2023, le temps pour la Commission de traduire ses nouvelles règles par de nouveaux actes juridiques et d’installer le comité et le groupe d’experts qui l’assisteront.

Le DSA a quant a lui été publié le 27 octobre 2022. Il s’applique en deux temps : d’abord uniquement pour les très grandes plateformes en ligne et les très grands moteurs de recherche, quatre mois après que la Commission les aura désigné comme tels. Ensuite pour les autres plateformes, 15 mois après son entrée en vigueur (20 jours après la publication au JO de l’UE) soit le 16 février 2024.

Haine en ligne et contenus illicites : que fait l’Europe ?

Quels sont les acteurs visés ?

Les deux textes entrainent de nouvelles obligations pour les pays de l’UE et des entreprises qui y opèrent.

Toutefois, le DMA et le DSA ne ciblent pas exactement les mêmes acteurs. Pour le DMA, il s’agit exclusivement des grandes plateformes, celles qui “ont une forte incidence sur le marché intérieur, qui constituent un point d’accès important des entreprises utilisatrices pour toucher leur clientèle, et qui occupent ou occuperont dans un avenir prévisible une position solide et durable”, énumère le projet de règlement.

Plus précisément, une plateforme est définie comme “contrôleur d’accès” (entre une entreprise et un utilisateur) si elle cumule :

- une position économique forte : au moins 7,5 milliards d’euros de chiffre d’affaires réalisés dans l’Espace économique européen ou une capitalisation boursière / valeur marchande d’au moins 75 milliards d’euros avec une activité dans au moins trois Etats membres ;

- le contrôle d’un “service de plateforme essentiel” (moteur de recherche, réseau social, messagerie, place de marché en ligne…) utilisé par au moins 45 millions d’Européens par mois et au moins 10 000 professionnels par an dans l’Union ;

- le dépassement de ces seuils au cours des trois années précédentes (caractère “solide et durable” de sa position sur le marché).

Les sociétés répondant à ces critères doivent en informer la Commission au plus tard deux mois après que ces seuils ont été atteints. Dans le cas contraire, celle-ci peut procéder à des enquêtes pour les identifier comme contrôleurs d’accès. Elle peut aussi décider de qualifier de contrôleur d’accès une société selon des critères plus qualitatifs ou, à l’inverse, exempter une société qui obéirait en théorie à la définition du contrôleur d’accès. Et elle peut décider de réévaluer régulièrement ces critères pour s’adapter à l’évolution de l’économie numérique.

Le texte prévoit également des exemptions pour raisons de santé publique et de sécurité publique, tandis qu’une catégorie de “contrôleur d’accès émergent” permet d’imposer certaines obligations aux entreprises susceptibles de “[jouir] d’une position solide et durable dans un avenir proche”.

Dans le cadre du DSA en revanche, toutes les entreprises proposant des “services intermédiaires” aux utilisateurs européens sont concernées : fournisseurs d’accès à internet, services en nuage, messageries, places de marché, réseaux sociaux… Des obligations supplémentaires sont prévues pour les hébergeurs, dont les plateformes, et plus encore pour les “très grandes plateformes” (plus de 45 millions d’utilisateurs actifs chaque mois, soit 10 % de la population européenne) ainsi que les “très grands moteurs de recherche en ligne” (plus de 45 millions de consommateurs de l’UE). Là encore, ces seuils pourront être ultérieurement revus.

Quelles sont les nouvelles règles prévues par le DMA ?

DMA et DSA ne répondent pas aux mêmes défis. La législation sur les marchés numériques (DMA) doit limiter les nombreux avantages grâce auxquels les contrôleurs d’accès peuvent conserver une position dominante sur le marché. Face à leurs pratiques parfois déloyales, le texte vise à imposer un certain nombre d’obligations ex ante : aujourd’hui, les amendes sanctionnant les infractions au droit de la concurrence interviennent souvent tard, ce qui n’incite pas les sociétés à modifier leur comportement en profondeur.

Avec le DMA, les contrôleurs d’accès n’ont plus le droit de favoriser leurs propres services et produits par rapport à ceux des entreprises qui les utilisent, ou d’exploiter les données de ces dernières pour les concurrencer. Ils ne peuvent pas imposer les logiciels les plus importants (comme les navigateurs ou les moteurs de recherche par exemple) par défaut à l’installation de leur système d’exploitation. Désinstaller des logiciels ou applications préinstallés sur son ordinateur, son téléphone ou sa tablette devient également possible dans la plupart des cas.

Le règlement garantit aussi la possibilité pour une entreprise utilisatrice de promouvoir son offre hors d’une plateforme à laquelle elle est liée, ainsi que de conclure des contrats avec ses clients ou proposer ses propres services aux consommateurs indépendamment de cette dernière.

Afin de faire la promotion de ses produits et services concurrentiels, une entreprise, et notamment un vendeur de biens en ligne, peut demander l’accès aux données générées par ses activités (performance marketing…). Elle peut également obtenir les informations liées aux annonces publicitaires qu’elle finance sur une plateforme.

L’accord entre le Conseil et le Parlement européen du 24 mars 2022 a ajouté plusieurs nouveautés au projet initial. Comme le souhaitaient les eurodéputés, une plateforme ne peut associer les données personnelles d’un utilisateur à des fins de publicité ciblée qu’en cas de consentement explicite. D’autres dispositions limitant la publicité ciblée sont prévues par le DSA.

Les principaux services de messagerie (Whatsapp, Facebook Messenger, iMessage…) doivent également être interopérables avec leurs concurrents plus modestes. Un utilisateur pourra ainsi envoyer des messages, des fichiers ou passer des appels vidéo depuis une application de messagerie vers une autre.

Enfin, les contrôleurs d’accès devront informer la Commission des acquisitions et fusions qu’ils réalisent.

Et par le DSA ?

La législation sur les services numériques (DSA) cherche de son côté à limiter la diffusion de contenus illicites (incitations à la haine ou à la violence, harcèlement, pédopornographie, apologie du terrorisme…) et la vente de produits illicites en ligne.

Afin de garantir ce principe, le DSA impose certaines obligations aux fournisseurs de services et notamment aux plateformes. Actuellement, les procédures de notification et de retrait de ces contenus et produits sont différentes d’un Etat membre à l’autre et ne permettent pas d’agir efficacement, les messages ou vidéos haineux étant par exemple supprimés longtemps après avoir été largement diffusés.

Si le DSA ne remet pas en cause la responsabilité limitée des plateformes vis-à-vis des contenus et produits illicites qu’elles hébergent (notion d’“hébergeur passif”), celles-ci devront en revanche proposer un outil permettant aux utilisateurs de les signaler. Une fois ce signalement effectué, elles devront alors retirer ces contenus et produits ou en désactiver rapidement l’accès.

Les plateformes ont l’obligation de coopérer avec des “signaleurs de confiance”. Il s’agit d’organes, associations ou individus labellisés au sein de chaque Etat en vertu de leur expertise et qui verront leurs notifications traitées en priorité.

Le DSA interdit par ailleurs de cibler des personnes avec des publicités en ligne basées sur leur religion, leurs préférences sexuelles, des informations sur leur santé ou leurs convictions politiques. La publicité ciblée est également interdite vis-à-vis des mineurs.

La publicité ciblée et la politique de modération des plateformes sont soumises à des obligations de transparence. Les plateformes doivent notamment expliquer le fonctionnement de leurs systèmes de recommandation, qui renforcent la visibilité de certains contenus pour un utilisateur en fonction de ses intérêts personnels. Les très grandes plateformes en ligne et les très grands moteurs de recherche ont également l’obligation de proposer aux utilisateurs un système de recommandation alternatif non fondé sur leur profilage.

Les “pièges à utilisateurs” (“dark patterns”), qui conduisent notamment les internautes à effectuer des actions non souhaitées sur un site au bénéfice de ce dernier, sont interdits.

Les très grandes plateformes, elles, seront par ailleurs tenues d’évaluer et de prendre des mesures pour atténuer les risques qui découlent de l’utilisation de leurs services : diffusion de contenus illicites, effets négatifs sur la vie privée et familiale, atteintes à la liberté d’expression… Elles devront réaliser chaque année cette analyse de réduction des risques sous le contrôle de la Commission européenne.

Les places de marché en ligne, qui réunissent des vendeurs et des consommateurs comme Amazon ou Airbnb, devront quant à elles afficher un certain nombre d’informations relatives aux produits et services qu’elles vendent, et détenir des informations permettant de tracer les vendeurs de biens et services illicites.

Le DSA impose à toutes les entreprises fournissant des services en ligne aux Européens de désigner un représentant légal dans au moins un pays de l’UE. Celui-ci doit par exemple, dans le cas des plateformes, obéir à toute demande de retrait de contenu ou de produit dangereux de la part de l’un des 27 Etats membres.

Un “coordinateur des services numériques” au sein de chaque Etat pourra également enquêter, saisir la justice s’il constate des irrégularités et même sanctionner directement une entreprise dans certaines situations. Les 27 coordinateurs coopèreront au sein d’un “Comité” habilité à mener des enquêtes conjointes dans plusieurs Etats. Ils pourront également recommander à la Commission européenne d’activer un mécanisme de crise lors d’événements particuliers pour lutter contre la désinformation en ligne.

Tandis que les Etats membres doivent eux-mêmes surveiller les petites plateformes, la Commission dispose quant à elle d’un pouvoir exclusif de supervision des très grandes plateformes en ligne et des très grands moteurs de recherche, soit une trentaine de sociétés en principe. Une nouvelle responsabilité financée par les plateformes elles-mêmes, en fonction de la taille de leur service et à hauteur de 0,05 % maximum de leur revenu net annuel mondial.

Plusieurs dispositions du DSA visent à contrebalancer les mesures de contrôle des contenus afin de garantir le respect de la liberté expression. L’auteur d’un contenu illicite doit par exemple être informé avant le retrait de ce dernier. Il pourra contester gratuitement cette décision auprès de la plateforme (en plus de la justice) et demander une compensation financière à l’entreprise si celle-ci ne respecte pas le texte.

Si la législation sur les services numériques (DSA) vise à encourager la suppression des contenus illicites, les contenus préjudiciables (désinformation, canulars, manipulation…) licites ne sont pas concernés au même plan. Le texte a pour but de limiter leur propagation non par leur suppression, qui serait contraire à la liberté d’expression, mais en exigeant des plateformes qu’elles revoient les mécanismes (algorithmes) permettant leur amplification.

Ces contenus préjudiciables font également l’objet aujourd’hui d’une régulation européenne non contraignante, notamment via le code de bonnes pratiques contre la désinformation, signé par plusieurs grandes entreprises du numérique.

La politique numérique de l’Union européenne

Quelles sont les sanctions prévues ?

Si elle estime qu’un contrôleur d’accès ne respecte pas ses obligations prévues par le DMA, la Commission peut lui indiquer des mesures concrètes à mettre en œuvre. Si celui-ci persiste, il peut se voir infliger des amendes allant jusqu’à 10 % de son chiffre d’affaires mondial total. En cas de récidive, cette amende peut aller jusqu’à 20 % de ce chiffre d’affaires.

En cas de non-respect systématique du DMA (règles enfreintes au moins trois fois en huit ans), la Commission peut ouvrir une enquête de marché et, si nécessaire, imposer des mesures telles que l’interdiction d’acquérir d’autres entreprises pendant une période donnée.

La Commission européenne est responsable de la bonne application du règlement par les contrôleurs d’accès qu’elle aura désignés, ainsi que des éventuelles sanctions. Les autorités nationales de concurrence des Etats membres peuvent quant à elles ouvrir des enquêtes sur des infractions présumées et transmettre leurs conclusions à l’exécutif européen.

Dans le cadre du DSA, chaque Etat membre doit déterminer les sanctions applicables dans la limite de 6 % du revenu ou du chiffre d’affaires annuel de la société (plafond abaissé à 1 % en cas d’informations incorrectes ou de refus d’enquête sur place). Les astreintes sont limitées à 5 % du chiffre d’affaires quotidien. Pour les très grandes plateformes, la Commission peut contrôler elle-même le respect de la législation. Les entreprises qui ne respecteraient pas les règles de manière répétée pourront être interdites.

Pour donner à l’Union européenne les moyens de faire respecter l’ensemble de ces règles, la Commission européenne pourrait procéder au recrutement de plus de 200 personnes et créer un centre européen de haut niveau sur la transparence des algorithmes.